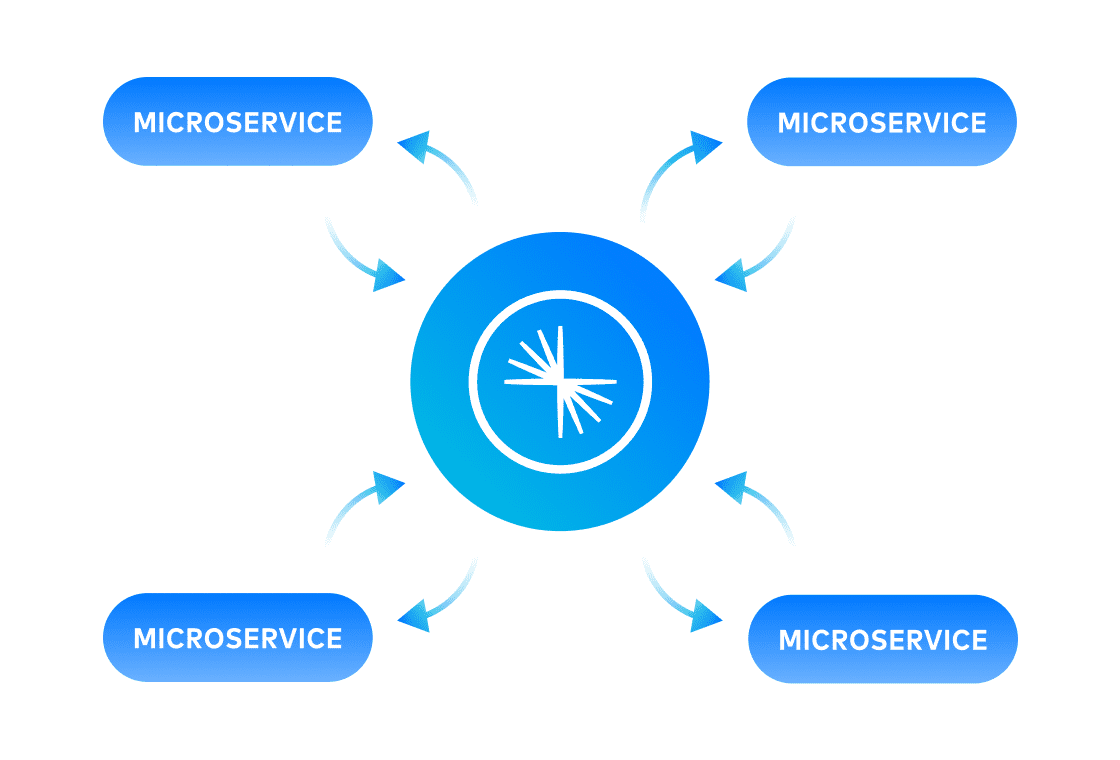

Microservices axés sur les événements

Boostez votre agilité et vos capacités d'innovation grâce à des microservices à couplage lâche. Utilisez Confluent pour découpler complètement vos microservices, standardiser la communication interservices et ne plus avoir à maintenir des états de données indépendants.